-

系统稳定性保障 – 微服务架构下如何做好故障演练

微服务架构场景中,应用系统复杂切分散。长期运行时,局部出现故障时不可避免的。如果发生故障时不能进行有效反应,系统的可用性将极大地降低。 文章目录 Toggle 什么是故障演练为什么需要故障演练故障演练的目标故障演练的基本流程云原生、微服务架构场景下故障模拟的挑战云原生、微服务场景下的故障演练工具如何进行故障演练演练前 | 确认演练对象与目标演练前 | 准备演练环境演练前 | 制定故障应对策略演练前…- 6

- 0

-

故障复盘 – 复盘工具 六顶思考帽复盘法

六顶思考帽不是思考者的类型。每个思考者都应该会用所有的帽子 。 白色思考帽:资料与信息 获得客观信息和认识,保证思维尊重事实。 红色思考帽:直觉与感情 决策时恰当的情感、直觉和预感 黄色思考帽:积极与乐观 进行统一的、逻辑的、深刻的负面论证。 黑色思考帽:逻辑与批判 进行统一的、逻辑的、不断的正面探索。 绿色思考帽:创新与冒险 不断实施出新奇的探索,寻求新的方法。 蓝色的思考帽:系统与控…- 2

- 0

-

数据治理 – XX业务数据分析体系的架构与实践

导读:讲述在业务快速迭代发展过程中,为了让大数据更好地赋能业务,高效的为用户提供有业务价值的数据产品和服务,百度爱番番的数据团队构建实时和离线大数据基础平台的心路历程,包括如何应对业务、技术、组织等方面的挑战和解决实际痛点过程中的思考与实践。 全文9911字,预计阅读时间24分钟。 文章目录 Toggle 一、前言1.1 名词解释三、实践及经验分享3.1 数据架构3.1.1 什么是数据架构3.1.…- 2

- 0

-

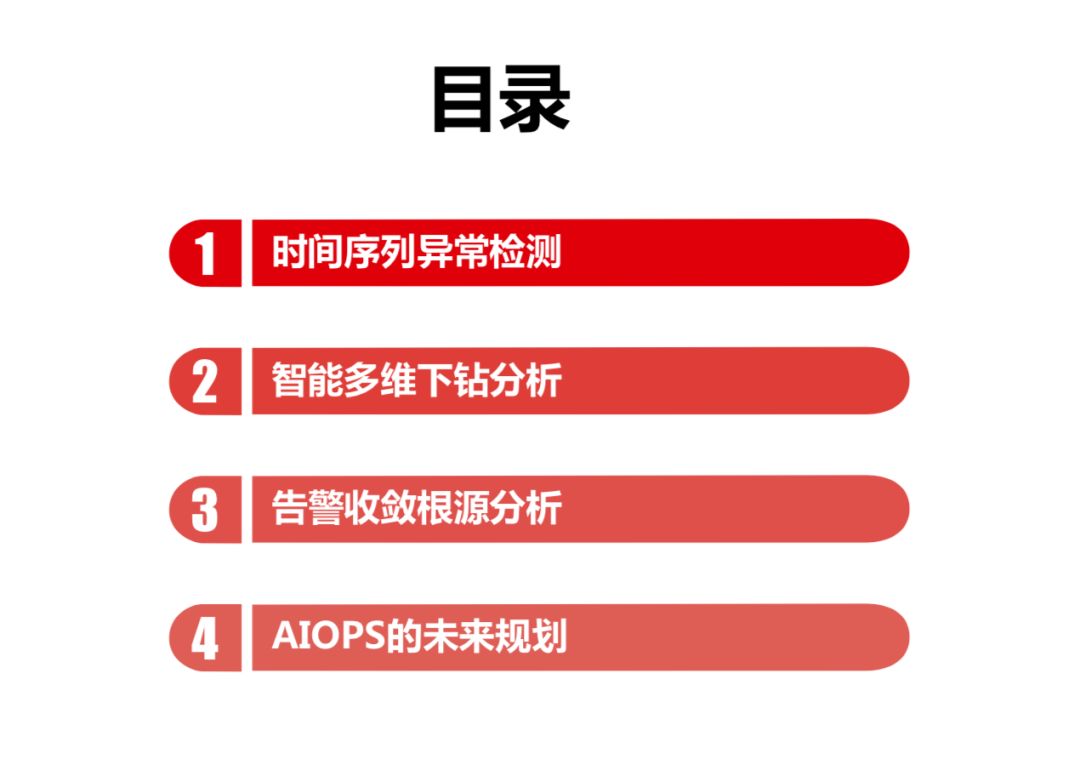

IT服务治理 – 腾讯运维的 AI 实践思路指引

讲师简介 张戎 机器学习研究员社交网络运营部 我是一个做机器学习的人,目前接触运维的时间并不长,大约半年左右。 主要做社交网络的运维、监控和异常检测方面的工作。本文将按照下面四大块内容分享。 1. 时间序列异常检测 监控领域做运维,最基础的是时间序列的异常检测。如果是基于机器学习的智能运维,主要分三个场景: 第一步是发现问题,如果我们无法发现问题就无法定位问题、甚至解决问题。 既然提到发现问题,最…- 2

- 0

-

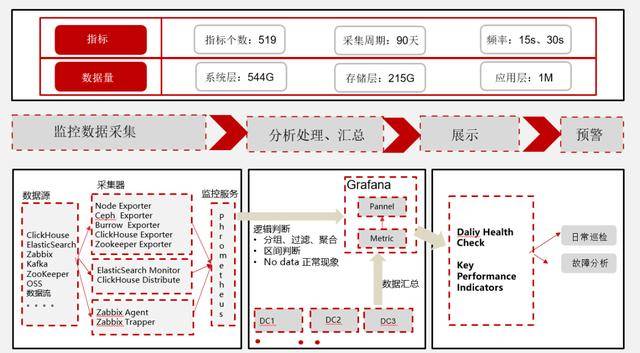

实践案例 – 百分点大数据技术团队:万亿级大数据监控平台建设实践

随着互联网业务的迅速发展,用户对系统的要求也越来越高,而做好监控为系统保驾护航,能有效提高系统的可靠性、可用性及用户体验。监控系统是整个运维环节乃至整个项目及产品生命周期中最重要的一环。百分点大数据技术团队基于大数据平台项目,完成了百亿流量、约3000+台服务器集群规模的大数据平台服务的监控,沉淀了一套适合自身业务和技术特点的监控架构设计思路、设计方法和落地方案。 本文主要从监控系统整体设计和技术…- 1

- 0

-

故障处理最佳实践 – ‘踩坑’、‘跳坑’、‘填坑’、‘避坑’

墨菲定律任何事情都没有表面看起来那么简单所有事情的发展都会比你预计的时间长会出错的事情总会出错如果担心某个事情发生,那么它更有可能发生 文章目录 Toggle 墨菲定律暗示我们,如果担心某种情况会发生,那么它更有可能发生,久而久之就一定会发生。这警示我们,在互联网公司,对生成环境发生的任何怪异现象和问题都不要轻视,对其背后的原因一定要调查清楚。同样,海恩法则也强调任何严重的事故背后都是很多次小问题…- 1

- 0

-

运维稳定性 -故障处理的系统稳定性与可观测性能力实践(系统稳定性保障)

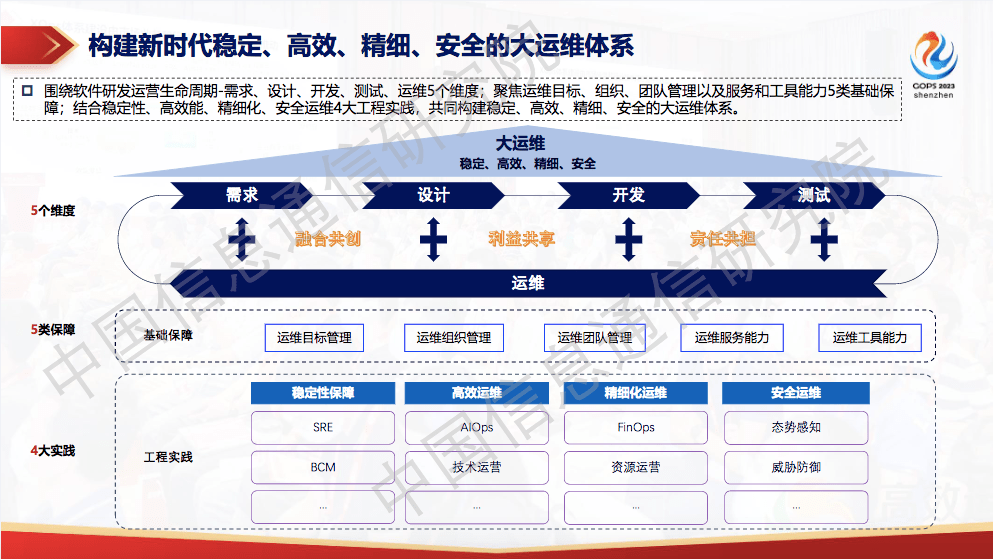

尚梦宸,中国信息通信研究院云计算与大数据研究所审计与治理部工程师。 一、构建新时代“大运维”体系 什么是“大运维”体系?它是运维发展过程中的一个阶段。在初始阶段,运维主要是辅助研发,运维方式主要是以手工为主,同时需要人工不断维护 更新。 随着数字技术发展及信息化的快速全面突破,研发侧逐渐向运维侧偏移,出现了自动化运维及研发与运维的协同,也即我们说的 DevOps。 DevOps 更多关注…- 5

- 0

-

故障治理 – 大促不慌,浅谈蘑菇街的稳定性保障

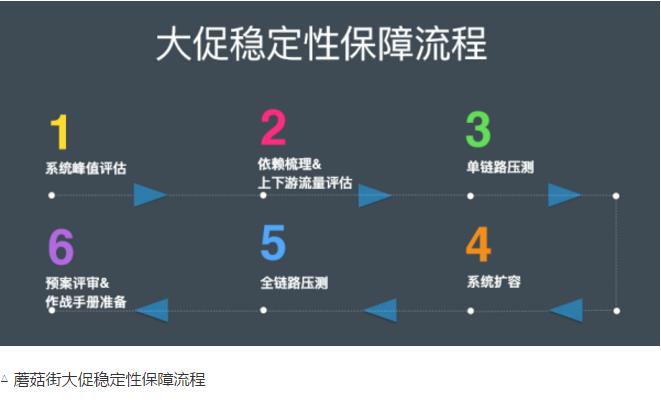

无相:开发了类似于全链路监控的工具,用于提升整条链路的稳定性。后开始负责全站稳定性工具和平台相关的工作,并参与了全流程加速系统的开发。 蘑菇街是一个电商平台,每年会做四次大促,3.21、6.18、双11、双12。大促保障涉及到流量评估、依赖梳理、单链路压测、全链路压测等。蘑菇街大促的基本流程,基本是按照系统峰值评估、依赖关系梳理、单链路压测、系统扩容、全链路压测等几个环节展开的。 在保障大促稳定性…- 2

- 0

-

IT 故障治理 – 运维救火必备:问题排查与系统优化手册(结合教训现身说法)

软件工程领域存在一个共识:维护代码所花费的时间要远多于写代码。而整个代码维护过程中,最惊心动魄与扣人心弦的部分,莫过于问题排查(Trouble-shooting)了。特别是那些需要 7×24 小时不间断维护在线业务的一线服务端程序员们,大大小小的问题排查线上救火早已成为家常便饭,一不小心可能就吃成了自助餐 —— 竖着进躺着出,吃不了也兜不住。 本文分享作者在服务端问题排查方面的一些经验,…- 3

- 0

-

稳定性保障 – 故障应急体系构建及应用实践(2)

本文主要介绍了蚂蚁集团大规模互联网系统中业务SRE的稳定性实践,包括业务SRE的定义、应急管理、大促稳定性保障等方面,具体内容如下: 1. 业务SRE定义 – SRE概念:SRE是结合软件工程和IT运维原则,通过编程和自动化提高系统稳定性、可扩展性和效率的实践和角色,业务SRE则专注于特定业务系统的可靠性和效率。 – 工作内容:确保业务系统稳定可用,优化性能提升用户体验,定…- 3

- 0

-

系统稳定性保障 – 相关能力成熟度模型介绍

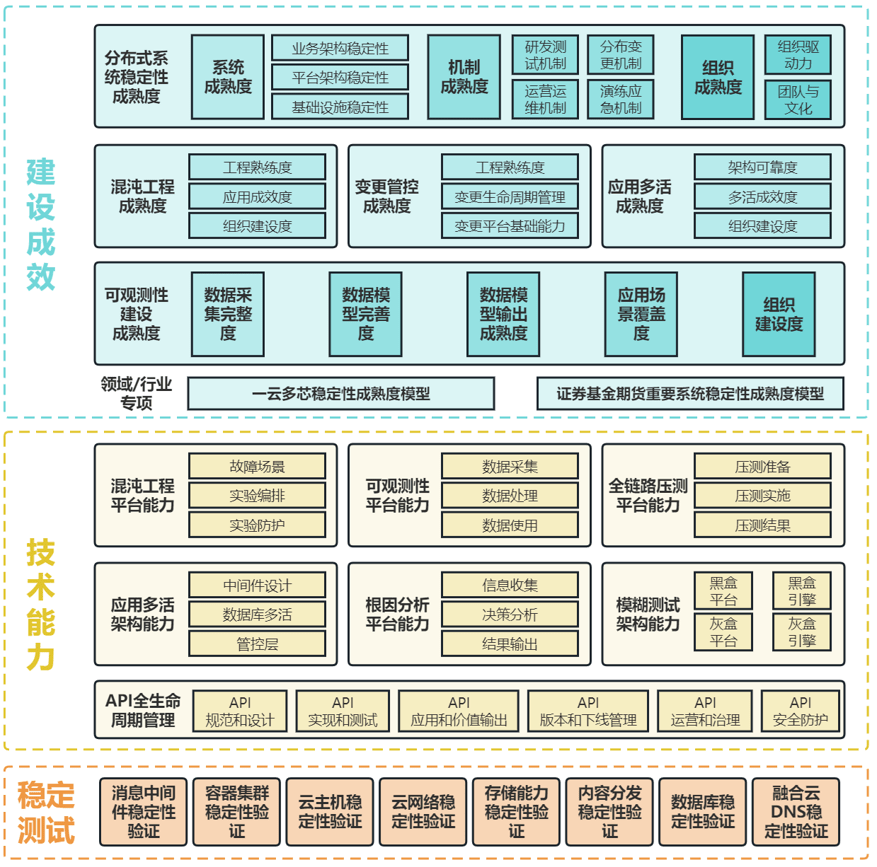

保障系统稳定性是现代软件开发中最具挑战性的问题之一,也是确保业务连续运行的重要因素。云服务、大型互联网平台、新型网络和关键业务的稳定安全运行,是我国信息通信行业高质量发展的基石,也是我国数字经济快速发展的必要条件。因此,针对系统稳定安全运行的技术研究和实践推广具有重要意义。 中国信通院自2020年起开始研究稳定性保障工作,建设了“系统稳定性保障系列标准”,并基于此标准体系支持了工信部稳定运行政策文…- 34

- 0

-

故障复盘 – 复盘工具 时间线分析法复盘

时间线分析法是一种通过构建事件时间轴来回顾和分析过程的方法。复盘时,将关键事件、决策点、里程碑等标注在时间线上,直观呈现项目或活动的全过程。 文章目录 Toggle 案例1:大促活动期间服务器崩溃案例2:商品详情页加载缓慢案例3:订单配送延迟 案例1:大促活动期间服务器崩溃 时间线: 促销活动前两周,技术团队进行系统压力测试和优化。 活动前一天,服务器负载测试达标,系统上线。 活动开始后两小时,访…- 4

- 0

-

IT服务管理:故障治理 – 运维故障排查处理思路

在讲解事件、故障处理思路前,先讲一个故障场景(以呼叫中心系统作为一例子): 业务人员反映呼叫中心系统运行缓慢,部份电话在自助语言环节系统处理超时,话务转人工座席,人工座席出现爆线情况。 运维人员开始忙活了,查资源使用情况、查服务是否正常、查日志是否报错、查交易量还有没有……时间不知不觉的在敲键盘、敲键盘、敲键盘中过去,但是原因还未定位。 经理过来了解情况:“系统恢复了吗?”、“故障影响是什么?”、…- 33

- 0

-

实践案例 – 告警治理 – 腾讯亿万量级告警是如何做到全、准、快的?

文章目录 Toggle 自我介绍监控的意义监控的手段监控的本质监控系统的目标——全、快、准全链路监控监控的速度统一上报协议准:智能监控海量监控的困扰ROOT智能监控系统降维策略时间相关性分析权重面积分析质量体系:生态构建天网体系天网:质量体系Q&AQ1:主动、被动、旁路,这三种在整个告警量的范围内,比例分别是怎样的?这三路产生的效果分别怎样?Q2:请教一下,报警之后就可以做自愈吗?Q3:有…- 3

- 0

-

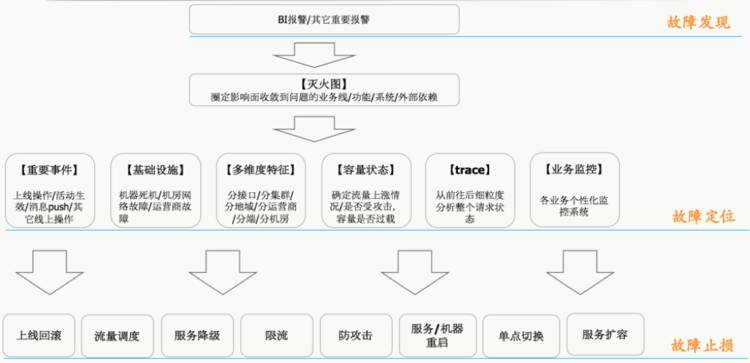

故障处理最佳实践 – 滴滴是如何高效处理线上故障的?

故障处理是每个系统都要面对的现实问题,但随着系统越来越复杂,故障的发现、定位、处理难度也将随之增大。滴滴现在服务近 4 亿乘客、1700 多万司机、覆盖 400 多个城市,超过 10 个业务线提供服务,业务的高速增长对稳定性工作来说是个极大的挑战。为了了解滴滴在故障处理以及稳定性建设方面的工作,InfoQ 记者采访了滴滴资深运维工程师张云柳。另外,张云柳也将会在 9 月 10 日举行的 CNUTC…- 7

- 0

-

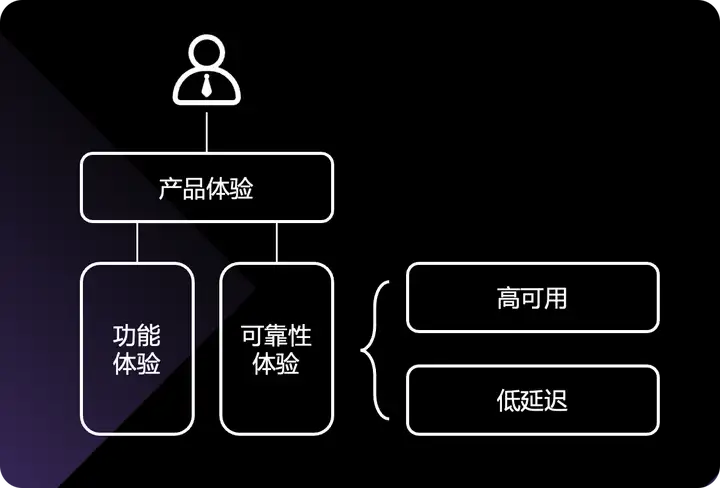

运维稳定性 – 故障处理的系统稳定性与可观测性能力实践

笔者从 12 年开始入行,从事 DevOps 研发工作,做过部署系统、监控系统、可观测性相关产品,也做过 SRE 一线和管理工作,对于可观测性的理解和实践,有一些小小的见解,利用本文和大家做一个探讨分享。本文主要内容包括: 可观测性在整个商业体系中的位置和价值 如何快速发现故障,使用哪类指标告警 SRE 在谈论故障定位的时候,谈的是什么 如何找到故障直接原因,找到止损依据 如何让可观测性系统呈现观…- 1

- 0

-

故障治理 – 全年配送0故障,盒马揭秘智能调度12个关键技术提高稳定性

文章目录 Toggle 一 、稳定大于一切二、智能调度链路分析三、稳定性因素分析和实践1、DB依赖2、HSF依赖3、HSF服务提供4、tair依赖5、Metaq依赖6、精卫依赖7、DTS依赖8、开关9、监控10、灰度11、测试12、应急响应四、总结 一 、稳定大于一切 盒马的线下作业稳定性要求极高,假如门店pos无法付款了,排起的支付长队伍能让人把门店闹翻,假如配送员无法揽收了,在家里预定的午餐材…- 4

- 0

-

经验教训 – 2015.09.20 从Amazon最新云停机事故中学到的三个教训(亚马逊云宕机事件)

Amazon刚刚经历的云服务停机事故引发业界对云技术的又一番争论。 就在上周日上午时段,Amazon Web Services数据中心遭遇一起相当严重的意外事故。 美国东部时间清晨六点,该公司负责承载AWS东弗吉尼亚区域负载的名为DynamoDB的大规模NoSQL数据库发生使用率暴涨状况——顺带一提,东弗吉尼亚州区域为该公司历史最悠久、规模***的九个全球性区域之一。到当日上午七点五十二分,AWS…- 2

- 0

-

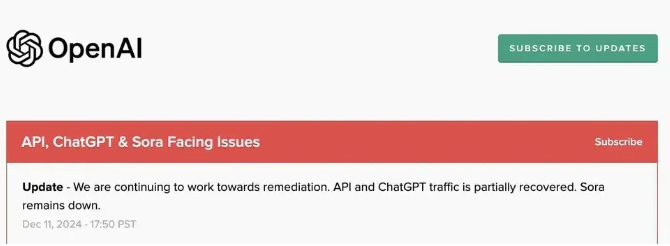

故障复盘 – 2024.12.11 OpenAI全球服务宕机复盘:技术架构的脆弱性与教训

2024年12月11日,OpenAI经历了一场全球范围的服务中断,持续时间超过四个小时,影响了ChatGPT、API、Sora等多个重要产品。宕机事件发生在当天太平洋时间下午3:16,直到晚上7:38才得以完全恢复。这一事件引发了行业对云服务架构的深刻反思,揭示了当前技术体系中潜在的脆弱性。 文章目录 Toggle 造成影响故障原因应急措施故障时间线预防措施 造成影响 ChatGPT:在下午5:4…- 5

- 0

-

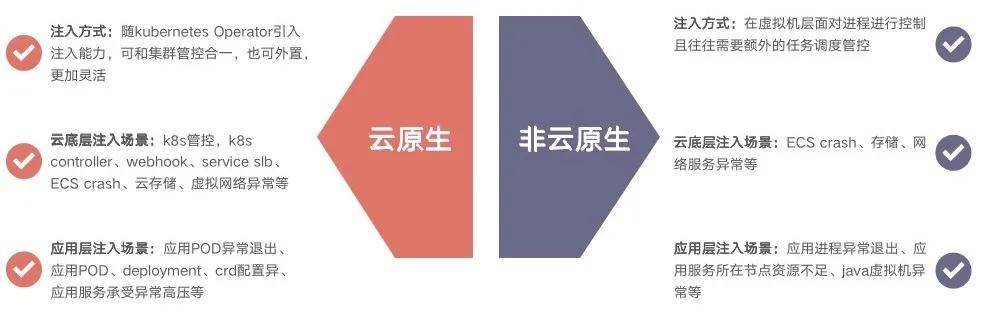

系统稳定性保障 – 云原生大潮下的混沌工程思考

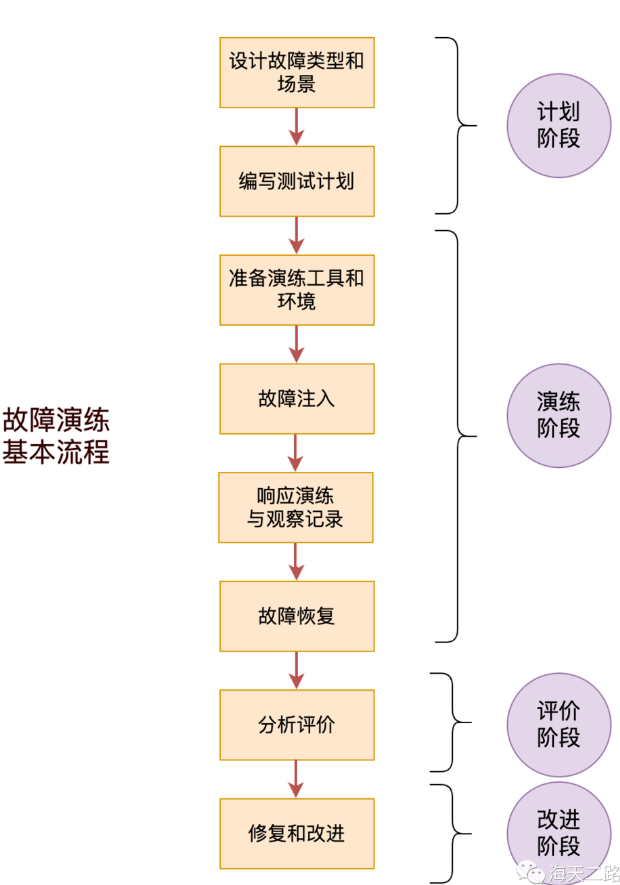

简介:生产环境的突袭演练是我们迈出的艰难但有力的一步,锻炼了研发运维人员的应急响应能力,在真实用户场景下锤炼系统,推进了产品的轮班制度,提升了云原生底座的稳定性和竞争力。 作者:智妍(郑妍)、浣碧(何颖) 文章目录 Toggle 什么是混沌工程,云原生大潮下的混沌工程特点混沌工程实施模式的阶段和发展如何进行一次完整的故障演练实施结语 什么是混沌工程,云原生大潮下的混沌工程特点 通过使用云计算厂商如…- 40

- 0

-

故障复盘 – 复盘工具 AAR(After Action Review/事后回顾)

AAR最早是美国陆军所进行的一项任务后的检视方法,对美国陆军来说,使用这种方法的好处是当新的理解被产生时,可以马上响应到行动上,他们使用AAR解决了许多问题。美国陆军使用AAR的成功因素包括:结构化、有目地的对谈;打破层级的藩篱;能迅速反映至行动中;将学习的成果记录下来等。在美国陆军的成功使用经验之后,Analog Devices公司T&IPD (Transportation & …- 10

- 0

-

2021.10.07 一行小错为何产生巨大破坏-Facebook史诗级故障大反思学习

Facebook大故障原因:一条写得很糟糕的命令、一款有缺陷的审核工具、一个阻碍成功恢复网络的DNS系统、以及严密的数据中心安全 Facebook故障是一系列不幸的事件酿成的! 一条写得很糟糕的命令、一款有缺陷的审核工具、一个阻碍成功恢复网络的DNS系统以及严密的数据中心安全,所有这些因素导致了Facebook长达 7 个小时的重大故障。 Facebook 表示,周一故障的根本原因是例行维护工作出…- 3

- 0

-

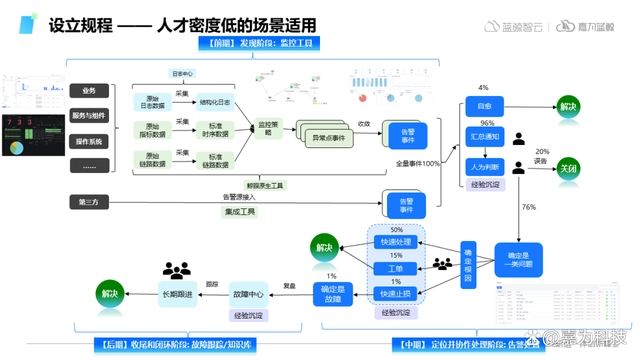

IT服务治理 – AIOps 在腾讯的探索和实践

1 从一个 NLP 故事说起 首先我想从一个 NLP 小的故事来说起。 在二十世纪三四十年代,人们大量尝试用机器的方式去理解自然语言,开始是用类似于左图一样的语法树的基于规则的方式处理的,但后来逐渐地变化为以统计的方式去做。 到了二十世纪七十年代之后,基于规则的句法分析逐渐地走到了尽头。 1972年的时候,自然语言处理领域大师贾里尼克加入了IBM。1974年左右,他在 IBM 提出了基于…- 7

- 0

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!